FOCUS BUSINESS

Le big data appliqué à la chaîne d’approvisionnement est porteur pour la mise en place de stratégies innovantes et pour accompagner les entreprises à dynamiser leurs opérations logistiques. En analysant toutes les données générées dans l’entrepôt, elles peuvent identifier des axes d’amélioration et ainsi être en mesure de prendre des décisions stratégiques.

Au cours des cinq dernières années, les appareils connectés à internet ont explosé. Une étude du cabinet de conseil International Data Corporation suggère que d’ici 2025, il y aura plus de 41 milliards d’appareils intelligents dans le monde : le nombre total d’appareils devrait produire plus de 79,4 zettaoctets de données en 2025.

La croissance exponentielle du volume de données générées, ou big data, offre une occasion unique d’améliorer les processus et la prise de décision dans les organisations. Selon la société de conseil en technologie, Gartner, « les big data sont des actifs informationnels à fort volume, à grande vitesse ou à grande variété qui nécessitent des moyens rentables et innovants de traitement de l’information afin de permettre une meilleure compréhension, une meilleure prise de décision et une meilleure automatisation des processus ».

L’analyse du big data facilite l’extraction d’informations utiles à partir de grands volumes de données. Afin de segmenter et de transformer les données, un large éventail de technologies big data a récemment vu le jour. Elles sont capables de collecter et traiter un énorme volume d’informations, impossible à analyser avec des logiciels traditionnels.

La technologie du big data est désormais appliquée dans toutes sortes d’entreprises et de domaines, que ce soit, par exemple, dans la production pour optimiser les performances ou dans le marketing pour segmenter le marché et obtenir des résultats optimaux.

Pourquoi le big data est-il essentiel pour les entreprises ?

Grâce à l’analyse des big data, les entreprises peuvent surveiller et traiter la grande quantité de données produites dans leur activité afin d’identifier de nouvelles opportunités.

Selon l'étude intitulée Big data analytics capabilities and knowledge management : impact on firm performance, « l’étude des big data permet d’analyser et de classer les données en informations utiles pour les entreprises, et de les transformer en processus décisionnels efficaces, ce qui stimule les performances ».

C’est précisément dans la prise de décision des entreprises que le big data commence à faire la différence. Une étude pluridisciplinaire de l’Anderson School of Management (États-Unis) et du College of Economics and Management (Chine) confirme le rôle stratégique des big data dans les entreprises : « Nos résultats empiriques montrent que l’utilisation de l’analyse des big data a un impact positif sur la qualité de la prise de décision ». Les auteurs de l’étude, publiée dans la revue universitaire Technological Forecasting and Social Change, relèvent le potentiel de l’analyse des big data pour améliorer la compétitivité des entreprises. « Les entreprises doivent non seulement promouvoir le big data dans leurs activités, mais aussi accroître leur capacité à analyser ces données, ce qui améliorera la qualité de leur prise de décision et leur avantage concurrentiel ».

Le big data dans la chaîne d’approvisionnement

Le big data ouvre un immense horizon d’opportunités pour les responsables de la chaîne d'approvisionnement. Un rapport d’Ernest & Young révèle que 61 % des cadres interrogés prévoient d’adopter l’analyse des big data au cours des trois prochaines années, tandis que 33 % pilotent déjà ou ont mis en œuvre des outils d’analyse des big data dans certains domaines de leur chaîne d’approvisionnement.

L’analyse des données apporte des avantages pendant la production, le stockage, le transport et la distribution des marchandises. Dans la publication académique Big data analytics in supply chain management, des chercheurs de la Western Illinois University (États-Unis) déclarent : « L’analyse des big data dans la gestion de la chaîne d’approvisionnement offre de nombreux avantages, comme la possibilité de mieux prévoir l’offre et la demande, d’analyser l’évolution des préférences des clients ou d’améliorer la visibilité de la chaîne d’approvisionnement, mais elle pose également de nouveaux défis aux organisations.

Grâce aux outils de big data, des méthodes d’analyse sont mises en œuvre pour favoriser une prise de décision éclairée dans la chaîne d’approvisionnement. « L’analyse des big data est apparue comme un moyen de faire des prédictions plus précises qui reflètent mieux les besoins des clients, facilitent l’évaluation des performances de la chaîne d’approvisionnement, augmentent l’efficacité de la chaîne d’approvisionnement, réduisent le temps de réaction et soutiennent l’évaluation des risques », expliquent les chercheurs de l’Institut d’ingénierie des systèmes d’information de Concordia (Canada).

Analyse de la chaîne d’approvisionnement : le big data appliqué à l’entrepôt

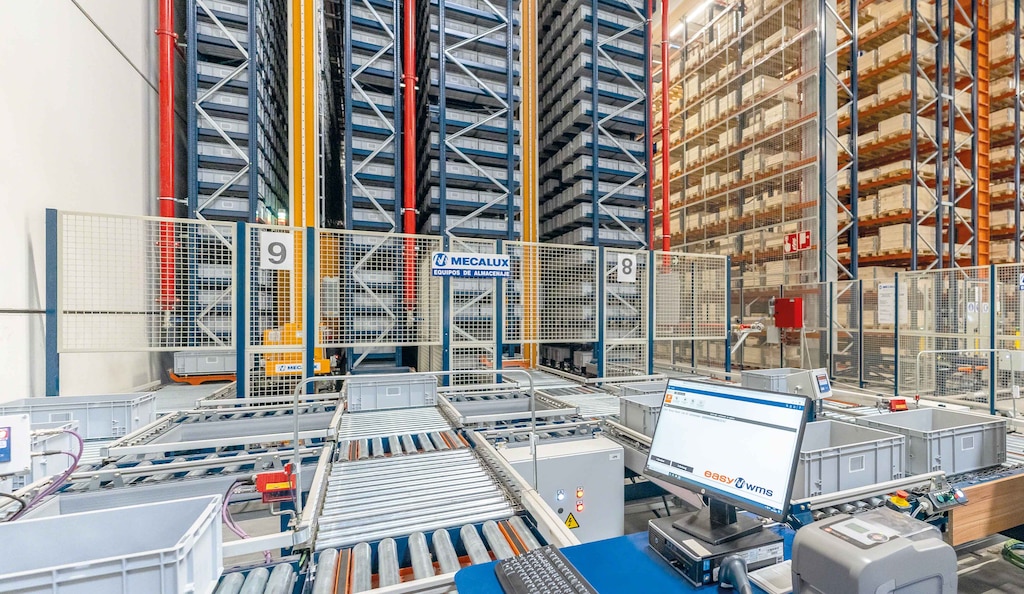

La digitalisation de la logistique implique l’utilisation d’appareils connectés au réseau qui génèrent une multitude de données. Pour faciliter leur analyse et leur interprétation, Mecalux a développé Supply Chain Analytics, une fonctionnalité avancée du logiciel de gestion d’entrepôt Easy WMS, qui segmente et structure les données provenant de toute installation.

En transformant la grande quantité de données de l’entrepôt en informations exploitables, le responsable logistique peut prendre des décisions plus facilement et plus précisément. Le programme d’analyse de la chaîne d’approvisionnement classe les données en indicateurs et présente un aperçu en temps réel des performances opérationnelles ainsi qu’une analyse historique des performances de l’installation.

Le logiciel intègre des panneaux de contrôle et des graphiques contenant les informations de base sur l’installation, comme le pourcentage d’articles en stock ou les lignes préparées. Il crée de même des indicateurs de performance qui peuvent être personnalisés en fonction des exigences de chaque gestionnaire logistique.

Le module Supply Chain Analytics contribue au développement d’une logistique souple et productive, adaptée aux besoins des entreprises. Par exemple, l’entreprise Intermark, spécialisée dans les produits d’emballage et d’étiquetage, a équipé son entrepôt du module d’analyse avancée de Mecalux afin d’avoir un suivi complet de ses opérations logistiques. « Le module montre comment les processus évoluent et nous aide à introduire des améliorations stratégiques sur la base des performances des opérations quotidiennes. Notre marché est très dynamique et les exigences des clients évoluent rapidement, ce qui nous oblige à transformer notre activité pour répondre aux demandes changeantes des clients. Grâce à ce module, nous disposons désormais d’informations fondées sur des données pour proposer des changements visant à améliorer notre logistique », explique Juan Pablo Calvo, PDG d’Intermark.

L’analyse des big data fournit aussi aux entreprises des données fiables et objectives pour modifier et optimiser leurs processus. « Easy WMS s’adapte parfaitement à notre activité. Grâce à ce système, nous pouvons connaître la disponibilité des références et du stock en temps réel », explique James Hansen, vice-président exécutif de Yamazen aux États-Unis. Le distributeur de machines-outils utilise le module Supply Chain Analytics Software pour consulter et analyser les performances de ses opérations de stockage.

Mecalux a mis en œuvre le module Supply Chain Analytics dans des installations logistiques du monde entier et pour des entreprises de multiples secteurs. Grâce à cette technologie, les entreprises intègrent le big data dans la gestion de leurs entrepôts dans le but de contrôler leur chaîne d’approvisionnement de bout en bout.

La puissance des données au service de la logistique

L’analyse des big data est utile dans toutes les industries, mais dans le secteur de la logistique, elle est essentielle. La grande quantité de données générées a un énorme potentiel pour favoriser la prise de décision stratégique.

Les entreprises choisissent la technologie pour interpréter la quantité colossale de données produites quotidiennement dans les différents secteurs de l’entreprise. L’analyse des big data ouvre la porte à de nouvelles possibilités d’amélioration telles que l’optimisation des opérations logistiques, la planification des investissements futurs ou le lancement de nouveaux produits ou projets.

Big data : une révolution en marche

En 1997, les chercheurs de la NASA Michael Cox et David Ellsworth ont introduit le concept de big data dans l’article Application-controlled demand paging for out-of-core visualisation. « La visualisation des processus pose un défi intéressant pour les systèmes informatiques : les ensembles de données sont souvent volumineux et mettent à rude épreuve la capacité de la mémoire principale, du disque local et même du disque externe. C’est ce que nous appelons le problème des grandes données : big data ».

Au début des années 2000, la démocratisation de l’internet a ouvert des possibilités uniques de collecte et d’analyse de données. Le développement des portails de vente en ligne a permis à des entreprises comme eBay ou Amazon de se concentrer sur l’analyse du comportement des clients pour augmenter le volume des ventes. Par la suite, l’essor des réseaux sociaux a intensifié le besoin d’outils permettant d’organiser la grande quantité de données non structurées provenant du web. Cependant, l’avènement de l’internet des objets (IoT) et du machine learning a renforcé l’utilisation des appareils connectés, multipliant les possibilités du big data.

Si les outils d’analyse des big data ont déjà fait leurs preuves, l’émergence de nouvelles technologies telles que le cloud computing ouvre de nouvelles voies pour exploiter le potentiel de l’analyse des données et optimiser les performances organisationnelles.

Les 5 V du big data

Le big data englobe cinq dimensions, connues comme « les 5 V » :

- Volume : l’énorme quantité d’informations provenant de sources multiples doit être gérée par de nouvelles formes avancées de gestion, d’exploitation et de stockage des données.

- Vélocité : le flux massif et constant de données à un rythme vertigineux nécessite des outils de collecte et de traitement agiles pour éviter l’obsolescence de toutes les informations collectées et analysées.

- Variété : les outils d’analyse des big data doivent non seulement traiter les sources écrites, mais aussi les images, les données informatiques, l’audio, la vidéo, ainsi que toutes sortes de contenus sur les réseaux sociaux et les nouvelles plateformes.

- Véracité : l’analyse des big data est confrontée à la nécessité de sélectionner les données véridiques pour une analyse ultérieure et d’écarter les informations non pertinentes.

- Valeur : si les données collectées ont été correctement sélectionnées et analysées, les informations obtenues seront d’une grande valeur pour l’organisation.